Diese Debatte um KI-Modelle und ihre Anbieter führen wir nicht erst seit gestern. Deshalb haben wir bereits zeitig Modellflexibilität als Designprinzip unserer KI-gestützten Workflows definiert. Welche Modelle wir an die Schnittstellen unserer Foresight- und Innovationsprozesse in PEACOQ anbinden, können wir jederzeit neu bewerten – je nachdem, was wir im Team und mit unseren Kund:innen als sinnvoll erachten.

Unser kostenloses Szenario-GPT war bewusst ein niedrigschwelliger Einstieg und als Format an einen Anbieter gebunden. Für produktive, plattformgestützte Workflows setzen wir dagegen auf Modellflexibilität, klare Datenstrukturen und nachvollziehbare Ergebnisse im Datenraum. Was genau hat es damit auf sich? Hier ein kleiner Überblick.

Der Anlass ist ernst. Und er betrifft nicht nur OpenAI. In der gesamten Tech-Branche fließen derzeit enorme Summen in die US-Politik: Großspenden an Super PACs, Millionen für Amtseinführungsfeiern, enge Verflechtungen mit der Trump-Administration. Doch bei OpenAI trifft es einen besonderen Nerv – denn das Unternehmen wurde einst als gemeinnützige Organisation gegründet, mit dem erklärten Ziel, KI zum Nutzen der gesamten Menschheit zu entwickeln.

Von diesem Anspruch ist wenig übrig. OpenAI-Mitgründer Greg Brockman und seine Frau haben 25 Millionen Dollar an ein Trump-nahes Super PAC gespendet. CEO Sam Altman gab eine Million Dollar für Trumps Amtseinführung. Das Unternehmen arbeitet an Verträgen mit dem Pentagon, hat seine Selbstverpflichtung gegen Militärprojekte still zurückgenommen, und Berichte zeigen, dass die US-Einwanderungsbehörde ICE KI-Tools auf Basis von GPT-Modellen einsetzt. Die Umwandlung von einer Nonprofit-Organisation in ein gewinnorientiertes Unternehmen rückt diesen Wandel zusätzlich ins Licht.

Wohlgemerkt: OpenAI ist kein Einzelfall. Auch andere Tech-Giganten – von Google über Amazon bis Meta – investieren kräftig in politische Netzwerke und Regierungsaufträge. Die Frage ist also breiter: Welchen Unternehmen vertrauen wir unsere KI-Infrastruktur an – und treffen wir diese Entscheidung bewusst?

Für uns bei Schaltzeit war das der Anstoß, eine Überzeugung, die wir schon länger haben, jetzt noch konsequenter in unsere Produkte und Prozesse zu übersetzen: Modellflexibilität.

Die Bequemlichkeitsfalle

Wenn heute jemand „KI“ sagt, denken die meisten an ChatGPT. Das ist verständlich – OpenAI hat früh eine beeindruckend einfache Oberfläche geschaffen, die Millionen Menschen den Zugang zu generativer KI eröffnet hat. Und genau darauf setzt das Unternehmen weiterhin: auf Gewöhnung. Auf die stille Annahme, dass es keine ernstzunehmenden Alternativen gibt.

Doch diese Annahme wird von Monat zu Monat brüchiger. Der KI-Markt hat sich grundlegend verändert. Modelle von Anthropic, Google, xAI, Meta, Mistral oder DeepSeek liefern in vielen Bereichen vergleichbare – oder sogar bessere – Ergebnisse. Was bleibt, ist vor allem eines: Bequemlichkeit. Und die Frage, ob wir uns davon leiten lassen wollen.

Was wir technisch beobachten

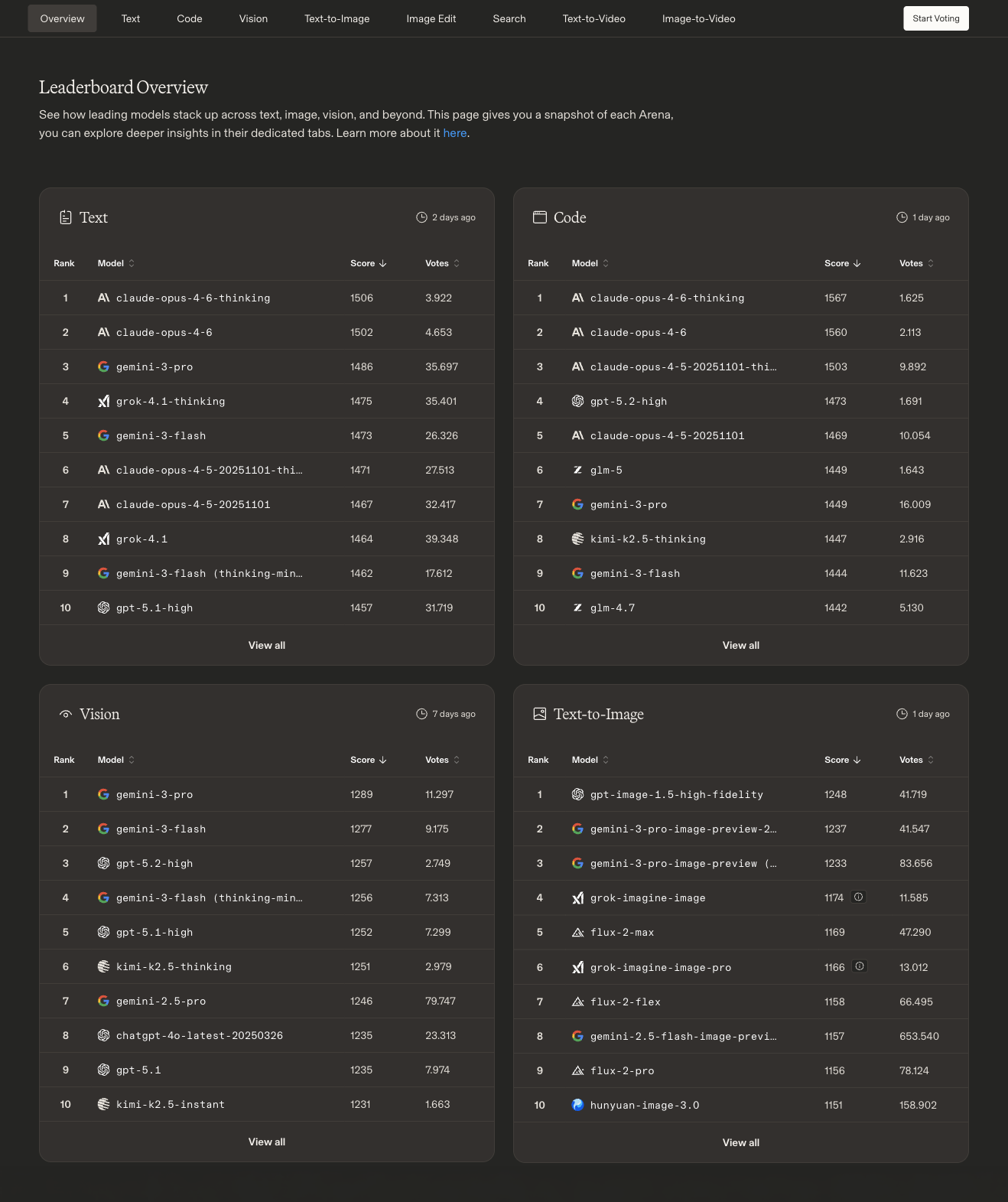

Wir beobachten die KI-Modelllandschaft kontinuierlich – nicht aus Spieltrieb, sondern weil es für unsere Arbeit und unsere Produkte entscheidend ist. Die aktuellen Benchmarks der LM Arena sprechen eine deutliche Sprache: Kein einzelner Anbieter dominiert über alle Kategorien hinweg.

Im Bereich Text führt derzeit Anthropics Claude Opus 4.6 das Ranking an – dicht gefolgt von Googles Gemini 3 Pro und xAIs Grok 4.1. OpenAIs aktuelles GPT-5.1 landet auf Platz 10. Der Abstand zwischen dem ersten und zehnten Platz? Gerade einmal drei Prozent. Im Code-Bereich ist das Bild ähnlich: Claude Opus 4.6 führt, gefolgt von seiner Vorgängerversion. OpenAIs GPT-5.2 erreicht Platz 4 – gleichauf mit chinesischen Modellen wie Kimi und GLM.

Besonders spannend wird es bei Vision und Suche: Googles Gemini 3 Pro dominiert sowohl bei visuellen Aufgaben als auch bei der webbasierten Suche. Bei der Bildgenerierung liegt OpenAIs GPT-Image knapp vorn, dicht gefolgt von Gemini und Grok. Und im Videobereich liefern sich Google Veo, Grok und OpenAIs Sora ein enges Rennen.

Die Botschaft ist klar: Es gibt nicht mehr „das eine beste Modell“. Je nach Aufgabe – ob Textanalyse, Coding, Bildverarbeitung oder Recherche – führen unterschiedliche Anbieter. Wer sich an einen einzigen bindet, verzichtet bewusst auf Leistung.

Neben der reinen Modellqualität gibt es einen weiteren Aspekt, der im Alltag oft unterschätzt wird: Tokens – also die Recheneinheiten, in denen KI-Modelle denken. Jede Anfrage, jede Antwort, jeder Kontext verbraucht Tokens. Und genau hier unterscheiden sich die Anbieter erheblich. Wer etwa intensiv mit Claude arbeitet, erreicht auf dem Pro-Plan schnell die Nutzungsgrenzen – manchmal mitten im Arbeitsprozess. Der Wechsel auf höhere Tarife kostet bis zu 200 Dollar im Monat. Bei OpenAI sieht es ähnlich aus: Wer KI-Tools für komplexe Aufgaben wie Coding oder Datenanalyse nutzt, verbrennt Token-Budgets in rasantem Tempo.

Die Preismodelle sind dabei alles andere als transparent. Token-Kosten variieren je nach Modell, Kontextlänge und Nutzungsart – und ändern sich regelmäßig. Für Organisationen, die KI als festen Bestandteil ihrer Arbeitsprozesse einsetzen, wird das schnell zur Planungsunsicherheit. Auch hier bieten Open-Source-Modelle einen Ausweg: Wer lokal arbeitet – etwa mit Ollama oder vergleichbaren Tools – hat keine Rate Limits, keine monatlichen Obergrenzen und volle Kontrolle über die Kosten.

Modellflexibilität bedeutet also nicht nur, das qualitativ beste Modell für eine Aufgabe wählen zu können. Es bedeutet auch, nicht von den Preisstrukturen und Nutzungsbeschränkungen eines einzelnen Anbieters abhängig zu sein.

Wenn Werkzeuge eine Haltung haben

Die technische Seite allein wäre schon Grund genug, über Modellvielfalt nachzudenken. Doch die politischen Entwicklungen in der KI-Branche machen aus einer technischen Überlegung eine Wertentscheidung.

Es geht nicht darum, einzelne Unternehmen an den Pranger zu stellen – die Verflechtungen zwischen Tech-Konzernen und Politik sind systemischer Natur. Es geht um eine grundsätzliche Frage: Wenn wir uns in unserer täglichen Arbeit auf KI-Werkzeuge stützen – welche Annahmen treffen wir dabei über die Unternehmen, die dahinterstehen? Und was passiert, wenn sich die Rahmenbedingungen ändern?

Dass OpenAI dabei besonders im Fokus steht, hat mit der Fallhöhe zu tun: Ein Unternehmen, das mit dem Versprechen antrat, KI zum Wohl der Menschheit zu entwickeln, und sich heute in Militärverträgen und politischen Großspenden wiederfindet – das ist mehr als ein strategischer Kurswechsel. Es ist ein Bruch mit den eigenen Gründungswerten.

In Europa kommt eine weitere Dimension hinzu: die digitale Souveränität. Über 80 Prozent der digitalen Infrastruktur in der EU stammt von Anbietern außerhalb Europas. Projekte wie Mistral AI in Frankreich oder das deutsche SOOFI-Projekt – ein mit 20 Millionen Euro gefördertes Open-Source-Sprachmodell – versuchen, hier Gegengewichte zu schaffen. Es tut sich etwas – aber der Weg ist noch weit.

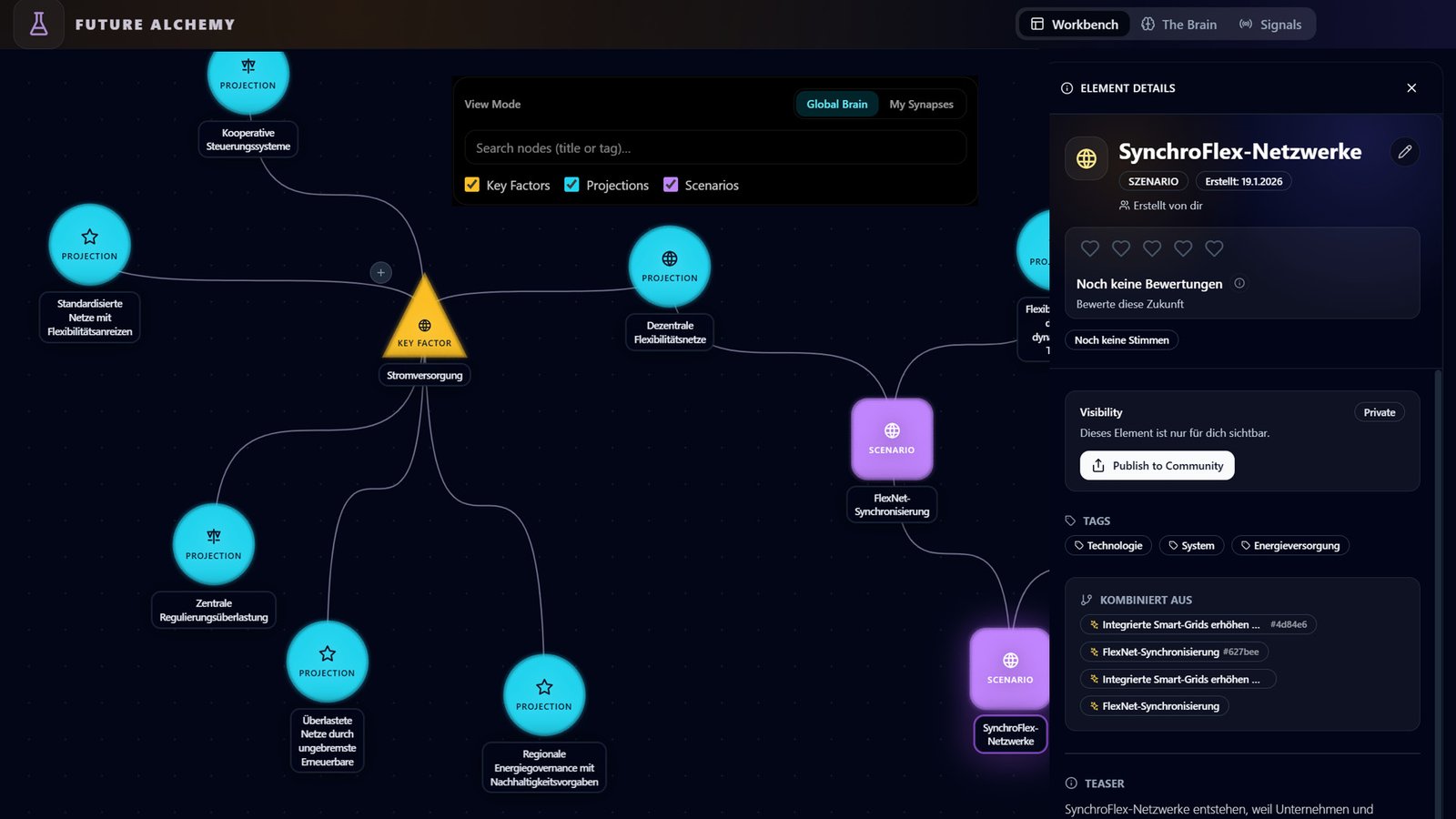

Modellflexibilität bei PEACOQ: Unsere Antwort

All diese Entwicklungen – technisch, politisch, ökonomisch – haben uns bestärkt, einen Weg konsequent weiterzugehen, den wir längst eingeschlagen haben: Modellflexibilität als Designprinzip.

In unserer Plattform PEACOQ (peacoq.net) integrieren wir zunehmend KI-Funktionen, die wir selbst entwickeln. Dabei ist Modellflexibilität kein nachträgliches Feature, sondern eine architektonische Grundentscheidung: Wir bauen PEACOQ so, dass unsere Kund:innen künftig selbst entscheiden können, welches Sprachmodell sie für ihre Anwendungsfälle nutzen möchten. Nicht wir treffen diese Wahl – sondern die Menschen, die mit der Plattform arbeiten.

Das heißt konkret: Ob ein Team lieber mit Claude, Gemini, einem Open-Source-Modell wie Llama oder einer lokal gehosteten Lösung arbeiten möchte – PEACOQ soll diese Wahlfreiheit ermöglichen. Denn wir glauben, dass Organisationen, die mit KI Zukünfte und Innovationen denken und gestalten wollen, nicht in die Abhängigkeit eines einzelnen Anbieters geraten sollten.

Auch in unseren Foresight-Prozessen und Workshop-Formaten setzen wir auf diese Vielfalt. Nächste Woche etwa sind wir beim Planungsamt der Bundeswehr zu Gast, im Rahmen eines Themenworkshops zu „KI in der strategischen Vorausschau“. Auch dort wird die Frage relevant sein, wie man mit Abhängigkeiten von einzelnen KI-Anbietern umgeht – gerade wenn es um sensible Anwendungskontexte geht.

Modellflexibilität ist für uns mehr als ein technisches Feature. Sie ist Ausdruck eines Grundprinzips: Wer Zukünfte und Innovation bewusst gestalten will, muss auch bei den Werkzeugen, die er dafür nutzt, bewusst wählen können.

Was wäre, wenn…?

Aus der Zukunftsforschung wissen wir, es ist wichtig, Annahmen sichtbar zu machen. Also fragen wir: Welche Annahmen stecken eigentlich hinter unserer KI-Nutzung?

„OpenAI wird immer das beste Modell haben“ – eine Annahme, die die aktuellen Benchmarks klar widerlegen. „Ein Anbieter reicht“ – eine Annahme, die technische und politische Risiken ignoriert. „Ethik ist bei Technologie-Entscheidungen nachrangig“ – eine Annahme, die wir nicht teilen.

Verschiedene Szenarien sind denkbar: Eine Welt, in der ein einzelnes Unternehmen den KI-Markt dominiert und damit auch beeinflusst, welche Fragen gestellt und welche Perspektiven sichtbar werden. Oder eine Welt, in der Vielfalt der Modelle auch Vielfalt der Perspektiven ermöglicht – in der Organisationen bewusst entscheiden, wem sie ihre Daten, ihre Prozesse und ihre Werte anvertrauen.

Wir arbeiten lieber am zweiten Szenario.

💬 Wie seht ihr das?

Wie geht ihr mit der Frage um, welche KI-Modelle ihr nutzt – und warum? Ist Modellwahl für euch eine rein technische Entscheidung? Oder spielen auch Werte, Souveränität und Unabhängigkeit eine Rolle?

Wir freuen uns auf den Austausch – schreibt uns per Mail, auf LinkedIn oder direkt im Gespräch.